NLP 코기

NLP 코기

|

[KO] Figure 이걸로 만들자. Paper Banana.

[KO] Figure 이걸로 만들자. Paper Banana.

|

2026-02-25 22:53:28

|

2026-02-25 23:05:28

|

x

|

NLP 코기

NLP 코기

|

[EN] Let's make figures with AI. Paper Banana

[EN] Let's make figures with AI. Paper Banana

|

2026-02-25 22:49:42

|

2026-02-25 23:05:29

|

x

|

NLP 코기

NLP 코기

|

[EN] Why are you guys do deep research only on text, this is visual feature era though.

[EN] Why are you guys do deep research only on text, this is visual feature era though.

|

2026-02-25 22:33:46

|

2026-02-25 23:05:30

|

x

|

NLP 코기

NLP 코기

|

[KO] 왜 Deep Research를 텍스트로만 하니? 시각 정보로도 하자

[KO] 왜 Deep Research를 텍스트로만 하니? 시각 정보로도 하자

|

2026-02-25 22:32:14

|

2026-02-25 23:05:30

|

x

|

NLP 코기

NLP 코기

|

[EN] Let's earn money with AI Quant

[EN] Let's earn money with AI Quant

|

2026-02-25 22:30:02

|

2026-02-25 23:05:30

|

x

|

NLP 코기

NLP 코기

|

[EN] Kimi K2.5

[EN] Kimi K2.5

|

2026-02-25 22:29:22

|

2026-02-25 23:05:31

|

x

|

NLP 코기

NLP 코기

|

[KO] Kimi K2.5

[KO] Kimi K2.5

|

2026-02-25 22:28:26

|

2026-02-25 23:05:31

|

x

|

NLP 코기

NLP 코기

|

[KO] AI 퀀트로 돈벌자

[KO] AI 퀀트로 돈벌자

|

2026-02-25 22:26:03

|

2026-02-25 23:05:32

|

x

|

NLP 코기

NLP 코기

|

[EN] Translation Reasoning Model

[EN] Translation Reasoning Model

|

2026-02-25 22:25:29

|

2026-02-25 23:05:32

|

x

|

NLP 코기

NLP 코기

|

[KO] 번역 리즈닝 모델

[KO] 번역 리즈닝 모델

|

2026-02-25 22:24:09

|

2026-02-25 23:05:32

|

x

|

NLP 코기

NLP 코기

|

[En] GUI World Model

[En] GUI World Model

|

2026-02-25 22:22:54

|

2026-02-25 23:05:33

|

x

|

NLP 코기

NLP 코기

|

[KO] GUI 월드 모델

[KO] GUI 월드 모델

|

2026-02-25 22:21:51

|

2026-02-25 23:05:33

|

x

|

NLP 코기

NLP 코기

|

[EN] How Well Do Large Reasoning Models Translate?A Comprehensive Evaluation for Multi-Domain ...

[EN] How Well Do Large Reasoning Models Translate?A Comprehensive Evaluation for Multi-Domain ...

|

2026-02-11 18:56:40

|

2026-02-13 17:05:29

|

x

|

NLP 코기

NLP 코기

|

[KO] How Well Do Large Reasoning Models Translate? A Comprehensive Evaluation for Multi-Domain

[KO] How Well Do Large Reasoning Models Translate? A Comprehensive Evaluation for Multi-Domain

|

2026-02-11 18:55:08

|

2026-02-13 17:05:29

|

x

|

NLP 코기

NLP 코기

|

[EN] Prompting Large Language Model for Machine Translation: A Case Study

[EN] Prompting Large Language Model for Machine Translation: A Case Study

|

2026-02-11 18:52:52

|

2026-02-13 17:05:30

|

x

|

NLP 코기

NLP 코기

|

[KO] Prompting Large Language Model for Machine Translation: A Case Study

[KO] Prompting Large Language Model for Machine Translation: A Case Study

|

2026-02-11 18:51:30

|

2026-02-13 17:05:31

|

x

|

NLP 코기

NLP 코기

|

[EN] Translating Step-by-Step: Decomposing the Translation Process for Improved Translation ...

[EN] Translating Step-by-Step: Decomposing the Translation Process for Improved Translation ...

|

2026-02-11 13:25:55

|

2026-02-13 17:05:31

|

x

|

NLP 코기

NLP 코기

|

[KO] Translating Step-by-Step: Decomposing the Translation Process forImproved Translation ...

[KO] Translating Step-by-Step: Decomposing the Translation Process forImproved Translation ...

|

2026-02-11 13:24:46

|

2026-02-13 17:05:32

|

x

|

NLP 코기

NLP 코기

|

[EN] K2-V2: A 360-Open, Reasoning-Enhanced LLM

[EN] K2-V2: A 360-Open, Reasoning-Enhanced LLM

|

2026-01-29 19:53:58

|

2026-01-29 20:05:20

|

x

|

NLP 코기

NLP 코기

|

[KO] K2-V2: A 360-Open, Reasoning-Enhanced LLM

[KO] K2-V2: A 360-Open, Reasoning-Enhanced LLM

|

2026-01-29 19:52:57

|

2026-01-29 20:05:21

|

x

|

NLP 코기

NLP 코기

|

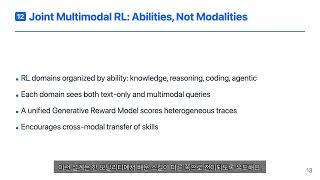

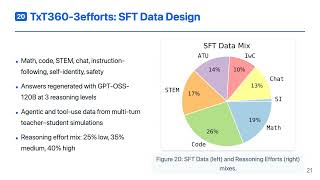

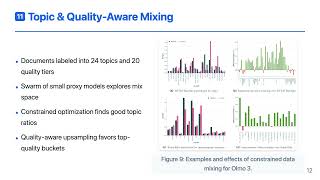

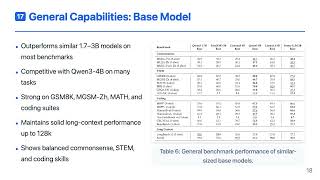

[EN] Olmo 3

[EN] Olmo 3

|

2026-01-29 19:51:08

|

2026-01-29 20:05:22

|

x

|

NLP 코기

NLP 코기

|

[KO] Olmo 3

[KO] Olmo 3

|

2026-01-29 19:50:25

|

2026-01-29 20:05:22

|

x

|

NLP 코기

NLP 코기

|

[EN] TranslateGemma Technical Report

[EN] TranslateGemma Technical Report

|

2026-01-29 19:48:37

|

2026-01-29 20:05:22

|

x

|

NLP 코기

NLP 코기

|

[KO] TranslateGemma Technical Report

[KO] TranslateGemma Technical Report

|

2026-01-29 19:48:06

|

2026-01-29 20:05:23

|

x

|

NLP 코기

NLP 코기

|

[EN] Youtu-LLM: Unlocking the Native Agentic Potential forLightweight Large Language Models

[EN] Youtu-LLM: Unlocking the Native Agentic Potential forLightweight Large Language Models

|

2026-01-29 19:46:46

|

2026-01-29 20:05:23

|

x

|

NLP 코기

NLP 코기

|

[KO] Youtu-LLM: Unlocking the Native Agentic Potential forLightweight Large Language Models

[KO] Youtu-LLM: Unlocking the Native Agentic Potential forLightweight Large Language Models

|

2026-01-29 19:45:31

|

2026-01-29 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[EN] GDPO: Group reward-Decoupled NormalizationPolicy Optimization for Multi-reward RLOptimization

[EN] GDPO: Group reward-Decoupled NormalizationPolicy Optimization for Multi-reward RLOptimization

|

2026-01-29 19:44:27

|

2026-01-29 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[KO] GDPO: Group reward-Decoupled Normalization Policy Optimization for Multi-reward RL Optimization

[KO] GDPO: Group reward-Decoupled Normalization Policy Optimization for Multi-reward RL Optimization

|

2026-01-29 19:43:31

|

2026-01-29 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[EN] Youtu-Agent: Scaling Agent Productivity withAutomated Generation and Hybrid Policy Optimization

[EN] Youtu-Agent: Scaling Agent Productivity withAutomated Generation and Hybrid Policy Optimization

|

2026-01-21 19:59:15

|

2026-01-21 20:05:20

|

x

|

NLP 코기

NLP 코기

|

[KO] Youtu-Agent: Scaling Agent Productivity withAutomated Generation and Hybrid Policy Optimization

[KO] Youtu-Agent: Scaling Agent Productivity withAutomated Generation and Hybrid Policy Optimization

|

2026-01-21 19:58:30

|

2026-01-21 20:05:21

|

x

|

NLP 코기

NLP 코기

|

[EN] mHC: Manifold-Constrained Hyper-Connection

[EN] mHC: Manifold-Constrained Hyper-Connection

|

2026-01-21 19:56:27

|

2026-01-21 20:05:22

|

x

|

NLP 코기

NLP 코기

|

[KO] mHC: Manifold-Constrained Hyper-Connection

[KO] mHC: Manifold-Constrained Hyper-Connection

|

2026-01-21 19:55:14

|

2026-01-21 20:05:22

|

x

|

NLP 코기

NLP 코기

|

[EN] Naver Cloud HyperCLOVA X 32B Think — Independent Foundation Model Special Series (Part 5-2)

[EN] Naver Cloud HyperCLOVA X 32B Think — Independent Foundation Model Special Series (Part 5-2)

|

2026-01-21 19:52:05

|

2026-01-21 20:05:23

|

x

|

NLP 코기

NLP 코기

|

[KO] Naver Cloud HyperCLOVA X 32B Think - 독자 파운데이션 모델 특집 5-2

[KO] Naver Cloud HyperCLOVA X 32B Think - 독자 파운데이션 모델 특집 5-2

|

2026-01-21 19:51:12

|

2026-01-21 20:05:23

|

x

|

NLP 코기

NLP 코기

|

[EN] Naver Cloud HyperCLOVA X Omni 8B — Independent Foundation Model Special Series (Part 5-1)

[EN] Naver Cloud HyperCLOVA X Omni 8B — Independent Foundation Model Special Series (Part 5-1)

|

2026-01-21 19:46:27

|

2026-01-21 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[KO] Naver Cloud HyperClova X Omni 8B - 독자 파운데이션 모델 특집 5-1

[KO] Naver Cloud HyperClova X Omni 8B - 독자 파운데이션 모델 특집 5-1

|

2026-01-21 19:45:56

|

2026-01-21 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[EN] NC AI VAETKI Technical Report — Independent Foundation Model Special Series (Part 4)

[EN] NC AI VAETKI Technical Report — Independent Foundation Model Special Series (Part 4)

|

2026-01-21 19:42:05

|

2026-01-21 20:05:24

|

x

|

NLP 코기

NLP 코기

|

[KO] NC AI VAETKI Technical Report- 독자 파운데이션 모델 특집 4

[KO] NC AI VAETKI Technical Report- 독자 파운데이션 모델 특집 4

|

2026-01-21 19:41:25

|

2026-01-21 20:05:25

|

x

|

NLP 코기

NLP 코기

|

[EN] SKT A.X K1 — Independent Foundation Model Special Series (Part 3)

[EN] SKT A.X K1 — Independent Foundation Model Special Series (Part 3)

|

2026-01-11 23:00:12

|

2026-01-11 23:05:20

|

x

|

NLP 코기

NLP 코기

|

[KO] SKT A.X K1 - 독자 파운데이션 모델 특집 3

[KO] SKT A.X K1 - 독자 파운데이션 모델 특집 3

|

2026-01-11 22:59:04

|

2026-01-11 23:05:20

|

x

|

NLP 코기

NLP 코기

|

[EN] K-EXAONE — Independent Foundation Model Special Series (Part 2)

[EN] K-EXAONE — Independent Foundation Model Special Series (Part 2)

|

2026-01-11 22:28:33

|

2026-01-11 23:05:21

|

x

|

NLP 코기

NLP 코기

|

[KO] K-EXAONE - 독자 파운데이션 모델 특집 2

[KO] K-EXAONE - 독자 파운데이션 모델 특집 2

|

2026-01-11 22:27:26

|

2026-01-11 23:05:21

|

x

|

NLP 코기

NLP 코기

|

[EN] Solar Open 100B — Independent Foundation Model Special Series (Part 1)

[EN] Solar Open 100B — Independent Foundation Model Special Series (Part 1)

|

2026-01-11 10:24:22

|

2026-01-11 11:05:19

|

x

|

NLP 코기

NLP 코기

|

[KO] Solar Open 100B - 독자 파운데이션 모델 특집 1

[KO] Solar Open 100B - 독자 파운데이션 모델 특집 1

|

2026-01-11 10:24:04

|

2026-01-11 11:05:20

|

x

|

NLP 코기

NLP 코기

|

[EN] Let’s Dive into DeepSeek R1

[EN] Let’s Dive into DeepSeek R1

|

2026-01-09 20:40:02

|

2026-01-09 21:05:20

|

x

|

NLP 코기

NLP 코기

|

[KO] Deep seek R1

[KO] Deep seek R1

|

2026-01-09 20:39:02

|

2026-01-09 21:05:21

|

x

|

NLP 코기

NLP 코기

|

[EN] Let’s Build an Agent for Writing Papers

[EN] Let’s Build an Agent for Writing Papers

|

2025-12-28 20:40:06

|

2025-12-28 21:05:10

|

x

|

NLP 코기

NLP 코기

|

[KO] 논문쓸 때 쓰는 Agent를 만들자

[KO] 논문쓸 때 쓰는 Agent를 만들자

|

2025-12-28 20:39:05

|

2025-12-28 21:05:10

|

x

|

NLP 코기

NLP 코기

|

[KO] Let’s Remove the Layers That Don’t Do Any Work in LLMs

[KO] Let’s Remove the Layers That Don’t Do Any Work in LLMs

|

2025-12-28 19:25:51

|

2025-12-28 20:05:09

|

x

|

NLP 코기

NLP 코기

|

[KO] LLM에서 일안하는 레이어들을 없애자

[KO] LLM에서 일안하는 레이어들을 없애자

|

2025-12-28 19:24:55

|

2025-12-28 20:05:09

|

x

|

NLP 코기

NLP 코기

|

[KO] OpenAI가 말하는 AI 시대의 엔지니어팀이 일하는 방법

[KO] OpenAI가 말하는 AI 시대의 엔지니어팀이 일하는 방법

|

2025-12-23 23:08:30

|

2025-12-24 00:05:08

|

x

|

NLP 코기

NLP 코기

|

[KO] How OpenAI Describes the Way Engineering Teams Work in the AI Era

[KO] How OpenAI Describes the Way Engineering Teams Work in the AI Era

|

2025-12-23 23:08:30

|

2025-12-24 00:05:09

|

x

|

NLP 코기

NLP 코기

|

[EN] A Game AI Agent That Plays Genshin Impact?

[EN] A Game AI Agent That Plays Genshin Impact?

|

2025-12-17 22:47:53

|

2025-12-17 23:05:14

|

x

|

NLP 코기

NLP 코기

|

[KO] 원신을 플레이하는 게임 AI Agent?

[KO] 원신을 플레이하는 게임 AI Agent?

|

2025-12-17 22:44:57

|

2025-12-17 23:05:14

|

x

|

NLP 코기

NLP 코기

|

[EN] Let’s Build a Computer-Use Agent

[EN] Let’s Build a Computer-Use Agent

|

2025-12-17 22:23:12

|

2025-12-17 23:05:15

|

x

|

NLP 코기

NLP 코기

|

[KO] Computer Use Agent를 만들어보자

[KO] Computer Use Agent를 만들어보자

|

2025-12-17 22:21:40

|

2025-12-17 23:05:16

|

x

|

NLP 코기

NLP 코기

|

[EN] Can We Do Reasoning with Video Generation Models?

[EN] Can We Do Reasoning with Video Generation Models?

|

2025-12-17 22:08:20

|

2025-12-17 23:05:16

|

x

|

NLP 코기

NLP 코기

|

[KO] 비디오 생성모델로 Reasoning을 해보자?

[KO] 비디오 생성모델로 Reasoning을 해보자?

|

2025-12-17 22:07:41

|

2025-12-17 23:05:17

|

x

|

NLP 코기

NLP 코기

|

[EN] If You’re Considering Deploying Agents in Production, You Must Watch This!

[EN] If You’re Considering Deploying Agents in Production, You Must Watch This!

|

2025-12-14 12:08:33

|

2025-12-14 17:05:09

|

x

|

NLP 코기

NLP 코기

|

[KO] Agent를 상용을 고려하고 있다면 이 영상을 꼭 보셔야합니다! Agent운영의 철학:AgentOps

[KO] Agent를 상용을 고려하고 있다면 이 영상을 꼭 보셔야합니다! Agent운영의 철학:AgentOps

|

2025-12-14 11:58:23

|

2025-12-14 17:05:10

|

x

|